Cheguei a acreditar e incentivar o uso de algumas instruções de segurança no arquivo robots.txt para WordPress com o intuito de dificultar a vida dos hackers que fazem uso de técnicas de Google Hacking.

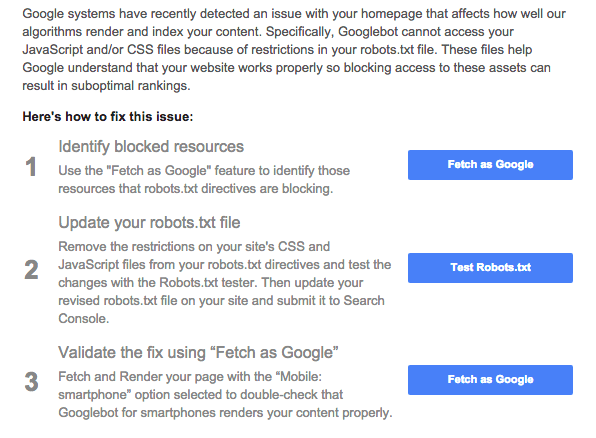

Recentemente o Google Search Console iniciou uma disparada de e-mails alertando gestores de sites sobre a impossibilidade do Googlebot poder acessar arquivos de CSS e JS.

O alerta na verdade é antigo. Matt Cutts falou sobre o assunto em 2012 afirmando que o Googlebot é inteligente o suficiente para lidar com os arquivos CSS e JS e compreender o seu site como um todo e não somente os textos. O buscador, além de se preocupar com a relevância, dá atenção à experiência do usuário e privilegia isso.

O CMS mais popular da atualidade tem uma tratativa coerente com os mecanismos de busca no âmbito de SEO e Segurança por padrão. Conhecer essas tratativas mais a fundo e pesquisar mais sobre o assunto me fez alinhar meu pensamento com a Yoast de manter um robots.txt simples e prático.

Como o WordPress lida com o arquivo robots.txt

Quando seu primeiro post é publicado, o WordPress cria um arquivo robots.txt virtual, ou seja, este arquivo não existe fisicamente na raiz do seu site. O WordPress detecta o acesso vindo de um bot e em caso positivo ele simula a existência do arquivo com as instruções. Se você fizer o uso do arquivo físico o WP deixa de oferecer o virtual.

Robots.txt para WordPress padrão

Por padrão, ele utiliza a seguinte instrução:

User-agent: * Disallow: /wp-admin/

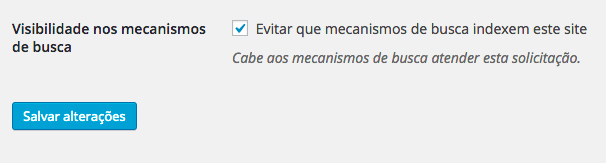

Robots.txt para WordPress padrão para evitar a visibilidade nos mecanismo de busca

Se você marcar a opção “Evitar que mecanismos de busca indexem este site” através das Configurações de Leitura a instrução utilizada no arquivo robots.txt seria esta:

User-agent: * Disallow: /

Robots.txt para WordPress segundo algumas autoridades

WordPress.org

User-agent: * Disallow: /search Disallow: /support/search.php Disallow: /extend/plugins/search.php Disallow: /plugins/search.php Disallow: /extend/themes/search.php Disallow: /themes/search.php Disallow: /support/rss Disallow: /archive/

WordPress.com

Sitemap: https://wordpress.com/sitemap.xml User-agent: IRLbot Crawl-delay: 3600 User-agent: * Disallow: /next/ User-agent: * Disallow: /mshots/v1/ # har har User-agent: * Disallow: /activate/ User-agent: * Disallow: /public.api/ # MT refugees User-agent: * Disallow: /cgi-bin/ User-agent: * Disallow: /wp-admin/

Ma.tt

User-agent: * Disallow: User-agent: Mediapartners-Google* Disallow: User-agent: * Disallow: /dropbox Disallow: /contact Disallow: /blog/wp-login.php Disallow: /blog/wp-admin

Yoast

User-Agent: * Disallow: /out/

A Yoast tem uma versão simplificada e desencoraja os mecanismos de busca a indexar sua área de afiliados. WordPress.org e WordPress.com tem diretivas específicas para os seus negócios, assim como o Matt.

Robots.txt para WordPress segundo a iniciativa WordPress Seguro

User-agent: * Disallow: /feed/ Disallow: /trackback/ Disallow: /wp-admin/ Disallow: /wp-content/ Disallow: /wp-includes/ Disallow: /xmlrpc.php Disallow: /wp

Como um fator de segurança para WordPress aconselhamos a adotação das diretivas acima no arquivo robots.txt. No entanto, isso impede o Googlebot de acessar arquivos CSS e JS. Os arquivos de temas e plugins estão aninhados na pasta /wp-content/ e as bibliotecas nativas da plataforma em /wp-includes/.

No lançamento da segunda versão do guia vamos desaconselhar o uso dessas diretivas e sugerir o uso de diretivas para casos específicos de acordo com a particularidade da sua aplicação. E com isso é impossível termos um código padrão.

O WordPress por padrão tem feito uso de meta tag e o cabeçalho HTTP X-Robots-Tag para desencorajar os mecanismos de busca nas páginas wp-login.php e em todas requisições AJAX na URL /wp-admin/admin-ajax.php.

Quais as diretivas com foco em segurança que você tem feito em seu arquivo robots.txt para WordPress?

Opa! Não conseguimos encontrar o seu formulário.